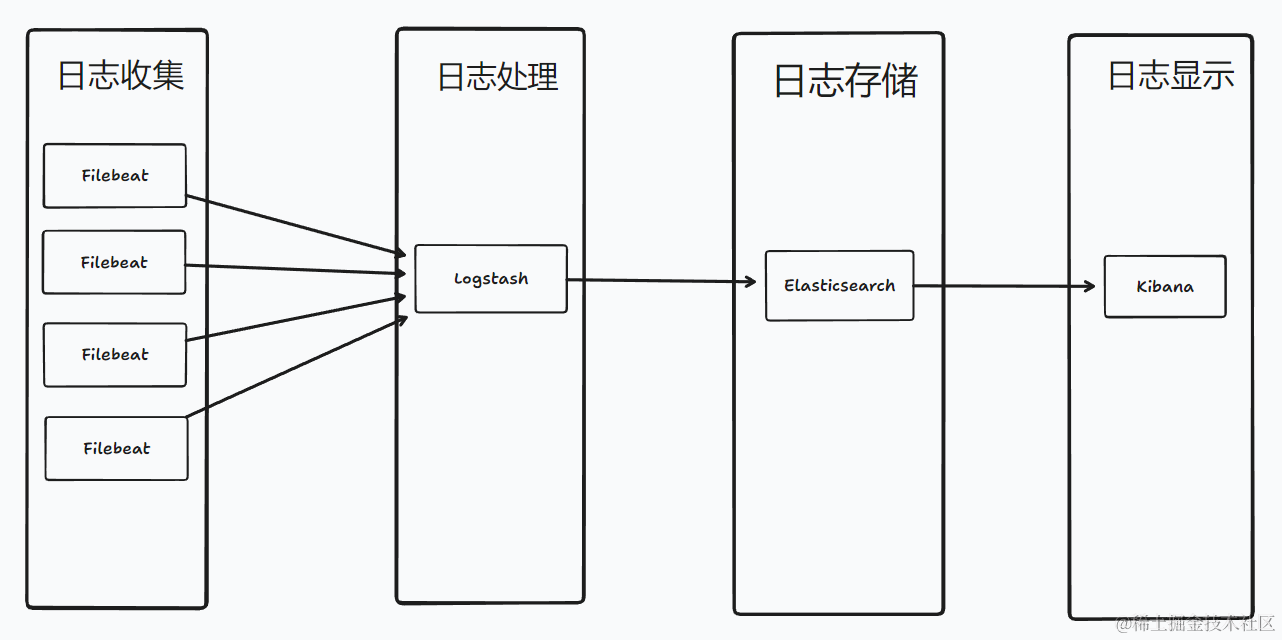

ELK的架構有多種,本篇分享使用的架構如圖所示: Beats(Filebeat) -> -> Elasticsearch -> Kibana,目前生產環境一天幾千萬的日誌,記憶體占用大概 10G ...

前言

ELK 是指 Elasticsearch、Logstash 和 Kibana 這三個開源軟體的組合。

Elasticsearch 是一個分散式的搜索和分析引擎,用於日誌的存儲,搜索,分析,查詢。

Logstash 是一個數據收集、轉換和傳輸工具,用於收集過濾和轉換數據,然後將其發送到 Elasticsearch 或其他目標存儲中。

Kibana 是一個數據可視化平臺,通過與 Elasticsearch 的集成,提供了強大的數據分析和儀錶盤功能。

Filebeat 是 Elastic Stack(ELK)中的一個組件,用於輕量級的日誌文件收集和轉發。它能夠實時監控指定的日誌文件,並將其發送到 Elasticsearch 或 Logstash 進行處理和分析。

ELK的架構有多種,本篇分享使用的架構如圖所示: Beats(Filebeat) -> -> Elasticsearch -> Kibana,目前生產環境一天幾千萬的日誌,記憶體占用大概 10G 左右

特點

- 開源免費

- 靈活性和可擴展性,高可用性,易擴展,支持集群

- 高效的搜索和分析功能

- 實時性

- 易於使用

使用情況

- 目前微服務項目使用,ELK單機部署,處理千萬級日誌無壓力

- 使用 Kibana 做了面板,根據面板監控系統情況

- 使用 Docker 部署,方便快捷

- 上手用還算簡單,但是弄懂這一套,就不是那麼容易了

- 提煉出 docker compose 配置,分分鐘部署好

實踐

準備

- 一臺 linxu 伺服器,記憶體 8G+

- 安裝 docker,docker compose

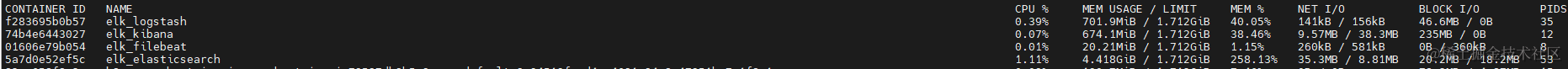

- 新機器搭建後的運行情況,限制了Elasticsearch的jvm參數 4g

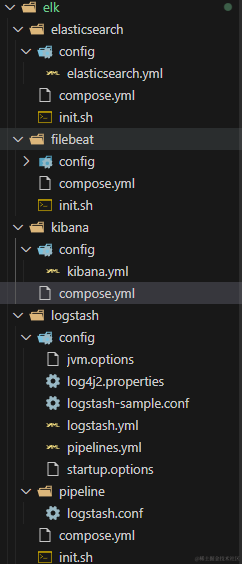

- 本篇文件目錄結構,完整文件在Github MeDevOps 倉庫

安裝

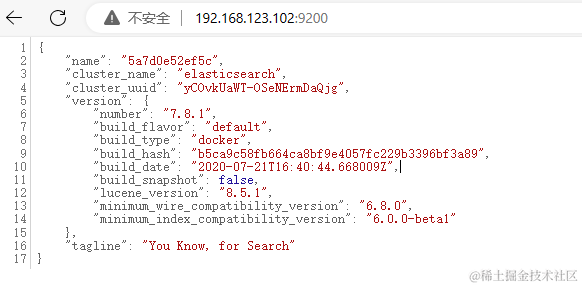

本篇 ELK 的版本為 v7.8.1,本篇使用的容器網路為 devopsnetwork ,需創建 docker network create devopsnetwork

Elasticsearch 使用 docker compose 安裝

-

compose.yml

- 指定了jvm參數:4g

- 暴露埠 9200:該埠是Elasticsearch REST API的預設埠。

- 暴露埠 9300:該埠是Elasticsearch節點之間的內部通信埠,預設用於節點之間的集群通信

- 掛載數據目錄

./data及配置文件./config/elasticsearch.yml - 需要對兩個目錄進行授權,這裡直接用了777,也可以根據官網使用對應es的用戶id 1000

version: '3.1'

services:

elk_elasticsearch:

image: elasticsearch:7.8.1

container_name: elk_elasticsearch

restart: always

environment:

- discovery.type=single-node

- ES_JAVA_OPTS=-Xms4096m -Xmx4096m

ports:

- 9200:9200

- 9300:9300

volumes:

# 授權 chmod 777 ./config/ && chmod 777 ./data/

- ./data:/usr/share/elasticsearch/data

- ./config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

networks:

- devopsnetwork

networks:

devopsnetwork:

external: true

- config/elasticsearch.yml

network.host: 0.0.0.0

xpack:

ml.enabled: false

monitoring.enabled: false

security.enabled: false

watcher.enabled: false

將其拷貝到伺服器執行啟動即可

#cd /app/elasticsearch

mkdir ./config

mkdir ./data

chmod 777 ./config/ && chmod 777 ./data/

docker compose up -d

驗證訪問

Logstash 使用 docker compose 安裝

-

compose.yml

- 暴露埠5044:用於接收來自其他主機的日誌數據、

- 掛載的

./pipeline和./config目錄可以運行容器複製出來 - 需要將./config/logstash.yml 和 ./pipeline/logstash.conf 改成es地址,參考

version: '3.1'

services:

elk_logstash:

image: logstash:7.17.16

container_name: elk_logstash

restart: always

ports:

- 5044:5044

volumes:

# 授權 chmod 777 ./logs/ && chmod 777 ./data/ && chmod 777 ./pipeline/ && chmod 777 ./config/

- /etc/timezone:/etc/timezone

- /etc/localtime:/etc/localtime:ro

- ./logs:/usr/share/logstash/logs

- ./data:/usr/share/logstash/data

- ./pipeline:/usr/share/logstash/pipeline

- ./config:/usr/share/logstash/config

networks:

- devopsnetwork

networks:

devopsnetwork:

external: true

-

pipeline/logstash.conf

- 根據需要修改 output ,這裡將推送到es地址中

- 輸出插件文檔

input {

beats {

port => 5044

codec => json {

charset => "UTF-8"

}

}

}

filter {

}

output {

elasticsearch {

hosts => ["http://192.168.123.102:9200"]

index => "%{[app]}-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

將其拷貝到伺服器執行啟動即可

mkdir ./data

mkdir ./logs

chmod 777 ./logs/ && chmod 777 ./data/ && chmod 777 ./pipeline/ && chmod 777 ./config/

docker compose up -d

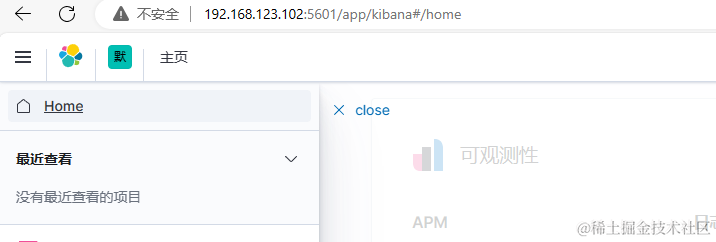

Kibana 使用 docker compose 安裝

-

compose.yml

- 指定es節點是單節點,多節點使用zen

- 掛載配置文件

./config/kibana.yml - 暴露埠 5601:面板訪問埠

version: '3.1'

services:

elk_kibana:

image: kibana:7.8.1

container_name: elk_kibana

restart: always

environment:

- discovery.type=single-node

ports:

- 5601:5601

volumes:

- ./config/kibana.yml:/usr/share/kibana/config/kibana.yml

networks:

- devopsnetwork

networks:

devopsnetwork:

external: true

- config/kibana.yml

server.host: "0.0.0.0"

elasticsearch.hosts: ["http://192.168.123.102:9200/"]

i18n.locale: "zh-CN"

xpack:

apm.ui.enabled: false

graph.enabled: false

ml.enabled: false

monitoring.enabled: false

reporting.enabled: false

security.enabled: false

grokdebugger.enabled: false

searchprofiler.enabled: false

將其拷貝到伺服器執行啟動即可

docker compose up -d

Filebeat 使用 docker compose 安裝

-

compose.yml

- 掛載filebeat的配置文件,數據目錄及日誌目錄,需要設置許可權

- 掛載容器外的日誌到容器內的日誌採集目錄

version: '3.1'

services:

elk_filebeat:

image: elastic/filebeat:7.8.1

container_name: elk_filebeat

restart: always

volumes:

# 授權 chmod 777 ./config/ && chmod 777 ./data/ && chmod 777 ./logs/ && chmod 777 /app/logs

- ./config/filebeat.yml:/usr/share/filebeat/filebeat.yml:ro

- ./data:/usr/share/filebeat/data

- ./logs:/usr/share/filebeat/logs

- /app/logs:/app/logs

networks:

- devopsnetwork

networks:

devopsnetwork:

external: true

-

config/filebeat.yml

- hosts 節點需要配置 logstash 地址

- paths 指定日誌目錄

output.logstash:

#logstash hosts

hosts: ["192.168.123.102:5044"]

fields_under_root: true

filebeat.inputs:

- type: log

enabled: true

paths:

- /app/logs/*/*.log

close_older: 24h

ignore_older: 24h

json.keys_under_root: true

json.overwrite_keys: true

encoding: utf-8

filebeat.config.modules:

path: ${path.config}/modules.d/*.yml

reload.enabled: false

setup.template.settings:

index.number_of_shards: 3

processors:

- add_host_metadata: ~

- add_cloud_metadata: ~

- drop_fields:

fields: ["log","@version","ecs","agent","beat","host","beat.hostname","beat.version","beat.name","prospector.type","input.type","host.id","host.name","host.os.build","host.os.family","host.os.name","host.os.platform","host.os.platform","log.file.path","tags","offset","host.architecture","host.os.version"]

安全使用

配置 nginx 功能變數名稱轉發

server {

listen 80;

listen 443 ssl;

server_name kibana.devops.test.com; # 自行修改成你的功能變數名稱

ssl_certificate /certs/kibana.devops.test.com/server.crt;

ssl_certificate_key /certs/kibana.devops.test.com/server.key;

ssl_session_cache shared:SSL:1m;

ssl_session_timeout 5m;

ssl_ciphers HIGH:!aNULL:!MD5;

ssl_prefer_server_ciphers on;

location / {

proxy_pass http://192.168.123.102:5601;

proxy_http_version 1.1;

proxy_buffering off;

proxy_request_buffering off;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_set_header Host $host;

proxy_set_header X-Forwarded-For $remote_addr;

}

}

配置完成,即可使用功能變數名稱訪問

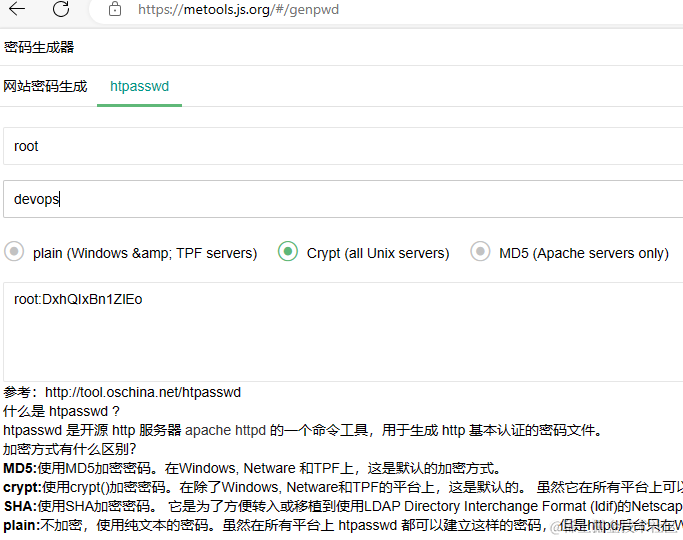

配置 nginx 基本認證

在Nginx配置文件中添加以下內容

location / {

auth_basic "Restricted Content";

auth_basic_user_file /certs/kibana.devops.test.com/passwd;

...

}

添加對應的passwd文件,使用 htpasswd 生成,如賬號密碼是 root devops666 的配置文件

root:WvesKBTr22.wY

配置完成,重載配置後刷新頁面就提示輸入賬號密碼了

配置 nginx IP白名單

location / {

allow 192.168.123.201; # 允許的IP地址

deny all; # 拒絕所有其他IP地址

}

後語

本篇只針對 ELK 的安裝進行了介紹及整理對應的 Docker Compose 配置文件,後續即可快速安裝配置 ELK 環境,如何與項目結合使用後續再分享

作者:易墨

Github:yimogit

純靜態工具站點:metools

說明:歡迎拍磚,不足之處還望園友們指出;

迷茫大概是因為想的太多做的太少。